|

Ci-dessous, un aperçu des stands et de l’organisation générale. Avid et Adobe organisaient des conférences quasiment en permanence, avec un succès tout aussi important que Newtek. |

Certains cherchaient à attirer l’attention par l’originalité du stand, comme en témoigne le terrain de golf reconstitué chez Panasonic… |

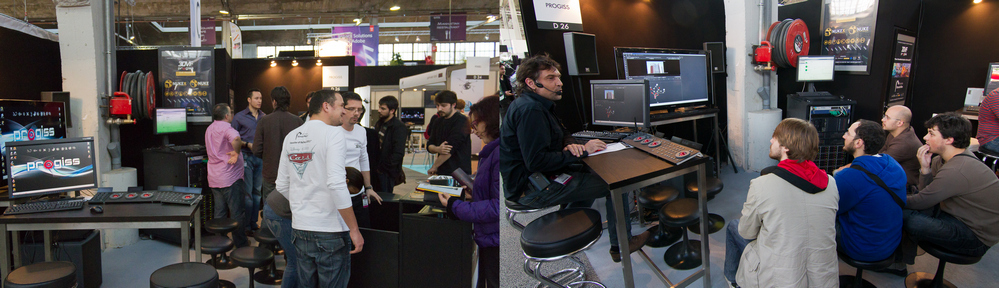

Le stand de notre partenaire Progiss, qui présentait ses solutions matérielles et logicielles, tout en proposant des démonstrations de logiciels : ci-dessous à droite, Nils Bessis revenant sur Nuke. Romain Donnot d’Assimilate est également intervenu sur le stand pour présenter le logiciel phare de l’éditeur : Scratch.

|

Finissons le tour des conférences par la table ronde autour du 4k, qui a eu lieu en présence de professionnels de profils variés, d’où une grande richesse dans le débat. Ce qui s’annonçait a priori comme une conférence technique a pris une tournure quasi philosophique très enrichissante. Étaient présents : |

Chaque intervenant a, à sa manière et à son niveau, une approche personnelle de la montée en résolution des images tournées en numérique. Voici un condensé des principaux points abordés : – Le 4k voire 5k permet de recréer un fossé avec la télévision, qui s’était atténué avec l’arrivée des téléviseurs grand format et HD : il s’agit pour le cinéma de proposer à nouveau un décalage net avec la télévision. |

|

– La tendance actuelle semble être de capter en sortie de la caméra le signal le plus brut possible, avec un traitement minimaliste au sein de la caméra, et de stocker directement l’image. On rejoint finalement en quelque sorte le RAW en photographie… Pour Emmanuel Pampuri des Machineurs, ceci peut créer deux grands courants : d’une part, ceux qui hurleront à l’horreur du changement, diront que tout était mieux avant, ce qui conduit à des logiques comme le développement de plugins pour rajouter du bruit. Évidemment, le spectateur pouvait faire le lien avec les films récents, voire les rendus fixes : entre les ajouts artificiels de lense flare, la conservation ou le rajout de bandes lumineuses horizontales ou verticales (initialement issues d’un défaut des capteurs numériques), les aberrations chromatiques pour le rendu fixe, la problématique est au coeur des oeuvres récentes. |

Patrick Leplat a alors enchaîné, notant que la méthodologie était encore non figée : avec l’arrivée du 4k ou 5k, ce sont tous les rôles de la chaîne de production qu’il faut repenser et redéfinir, dans un environnement changeant. Son espoir : parvenir à une nouvelle façon de gérer l’image, une nouvelle méthodologie qui permettra de retrouver de nouveaux repères, de nouveaux rôles quasi figés, qui resteront valables quelle que soit la résolution. – La pérennité est un problème important du numérique : les codecs évoluent, il faut donc prendre garde à pouvoir conserver durablement les productions. Ironiquement, même à l’heure actuelle le meilleur moyen de conservation semble être… De repasser le film numérique sur pellicule, support stable et que l’on saura relire sans difficulté dans plusieurs dizaines d’années. – Durant la séance de questions, la question de la projection argentique vs numérique a été abordée, un membre de l’audience étant un fervent défenseur de la projection sur pellicule, censée avoir mille qualités… Arguments qui ont été balayés par le panel : oui, bien entendu, la projection numérique actuelle peut montrer des problèmes d’étalonnage, ou de déformation géométrique (d’autant plus que durant la phase de transition, le projecteur numérique est souvent placé à côté du projecteur argentique, en biais et non pas sur la position idéale). Au final, cette conférence a sans doute été la plus intéressante de celles que nous avons pu voir : oscillant entre technique et philosophie, pragmatisme et réflexion sur l’avenir des métiers du cinéma, elle a soulevé bon nombre de questions… Pour lesquelles les réponses restent souvent à trouver. |

|

Pour en savoir plus : – Le site officiel du SATIS. |

|